Demandez le programme ! Et découvrez notre étude en partenariat avec GSI Network !

Plus votre site grossit et gagne en trafic, plus la charge (et les coûts) de vos serveurs et de votre infrastructure augmentent. Normal, nous direz-vous ? Eh bien pas tant que ça.

Avez-vous déjà eu l'occasion d'observer l'activité de votre infrastructure la nuit alors que votre trafic sur Analytics est on ne peut plus calme ? Nous oui…

Normalement, si vous n'avez pas de visiteurs, le site et son infra devraient être au repos, non ? Vous en êtes sûr ? Vous avez jeté un œil à vos logs ? Nous oui…

Aussi avons-nous étudié dans le détail l'activité de ces bots, leurs comportements et leurs usages et coutumes. Et croyez-nous, vous n'êtes pas au bout de vos surprises.

Observer le comportement des robots et autres crawlers revient à regarder un ciel étoilé pour, une fois la nuit tombée, voir la nuée de satellites qui gravitent autour de nous.

Cette observation via nos outils ressemble un peu à ça :

Pour nous faire une idée claire de la situation et capturer ces crawlers comme des fantômes dans un piège à neutrons (si vous avez la ref...) nous avons observé plusieurs sources, indicateurs et avons tendu des pièges... De quoi alimenter notre analyse.

Alors Jamie, mettons le protocole en place :

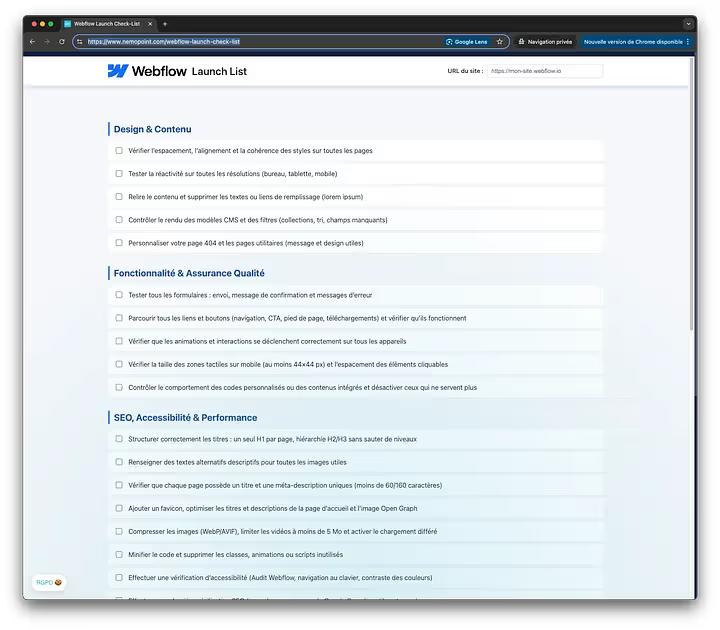

- Prenons les logs de l'équivalent de plusieurs centaines de sites sur une infrastructure multi-serveurs (principalement des WordPress, PrestaShop et projets Symfony).

- Mettons en place un agent IA et lançons-le dans l'apprentissage et l'analyse de ces millions de lignes de logs.

- Créons des masques de recoupement sur les IP, les User-Agents, la densité des hits.

Puis tendons des pièges :

- Prenons 3 LLM, au hasard Gemini, ChatGPT, Perplexity...

- Créons avec ces technologies des scripts et projets fictifs que nous allons déployer sur une pré-prod accessible à tous les vents et avec à chaque fois un système d'authentification et une dizaine de pages créées sur la base de contenus également générés par les LLM en question.

- Sur ces sites de dev accessibles mettons un bon vieux sitemap et notre fidèle robots.txt rempart contre l'indexation protégeant Babylone.

Tout est prêt, relevons maintenant les filets !

- En moyenne, environ 16% du trafic observé sur une période de 30 jours est généré par des bots suspects ou malveillants, et ce de jour comme de nuit. Avec des pics entre minuit et 6h du matin.

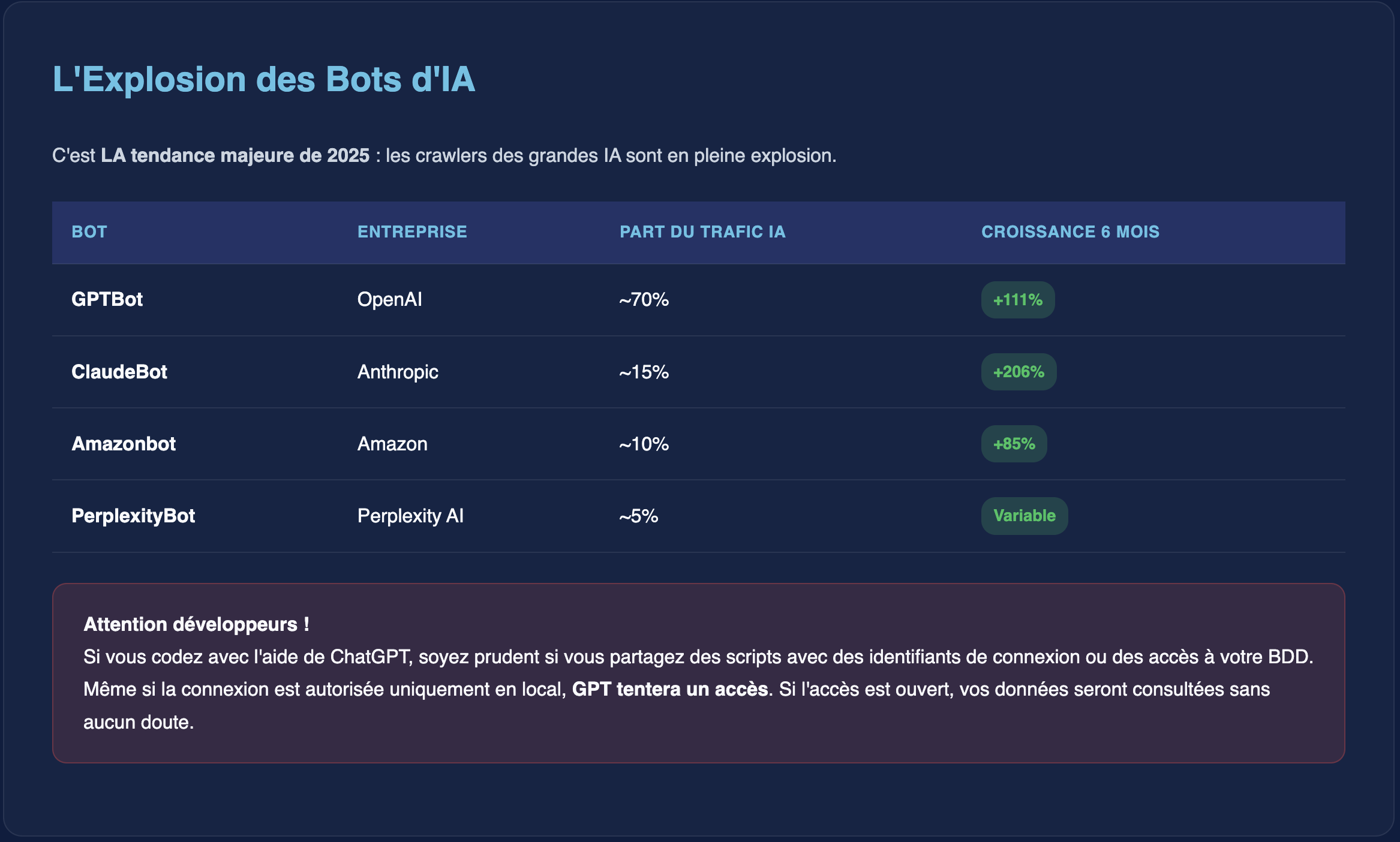

- Sur les 12 derniers mois on observe un accroissement du trafic des crawlers IA de +180% avec sur le podium :

- Googlebot (~40% du trafic bot)

- Bingbot (~25% du trafic bot)

- GPTBot d'OpenAI (~8% du trafic bot)

- Si vous "codez" avec l'aide de ChatGPT soyez prudent si vous partagez des scripts avec des identifiants de connexion ou des accès à votre BDD. Même si la connexion en question n'est autorisée qu'en local, GPT tentera un accès, si l'accès est Open vos données seront consultées sans aucun doute.

- Les répertoires que vous avez indiqués en Disallow sur votre robots.txt sont systématiquement consultés, et ce quel que soit le robot. C'est tellement tentant : comme un gros bouton rouge sur lequel il serait écrit "ne pas appuyer". Nous avons constaté qu'au final le robots.txt en plus de ne pas être respecté (même par Google) était comme un aimant à crawl.

- Coucou vous me reconnaissez ? C'est moi l'agent qui se fait passer pour Googlebot ou Bingbot alors que mon IP n'est pas du tout déclarée par ces entreprises : si vous pensiez (encore) que le User-Agent (UA) équivalent de la signature d'un robot était fiable, détrompez-vous (d'ailleurs la première fois que vous jouez avec les headers en PHP c'est le premier truc que vous testez pour le kiff).

- Ne soyez pas étonné si votre site est lent lorsque vous faites une analyse de positions/performances avec Ahrefs ou Semrush : son bot est capable en une seule session de générer pas moins de 20 000+ hits en moins de 30 minutes. Donc si vous faites ce genre d'analyse, assurez-vous que vous n'êtes pas en plein pic d'activité, de ventes, ou pendant vos soldes dans le cas d'un site marchand.

- Google, tous sites confondus, est en tête des charts suivi de près par Bing. Avec une intensification des crawls depuis 12 mois. Mais qu'on ne s'y trompe pas : Google reste fidèle à son leadership : quand ils crawlent ils sont capables de générer pas moins de 1 566 hits par minute (soit environ 94 000 hits par heure) loin devant tous ses compères.

- L'empire du milieu en force : même si vous n'y avez jamais mis les pieds et n'avez aucune indexation souhaitée dessus, Baidu est particulièrement vorace ces derniers mois.

- Il en va de même pour Yandex venu de Russie...

- Sur certains sites la proportion du trafic généré par des bots peut atteindre 90%

- Un constat : 80% de ces bots ne sont pas européens avec en tête les États-Unis (~65%), la France (~8%), la Russie (~6%) et l'Allemagne (~4%).

Quelques mesures et idées pour votre quotidien :

- Arrêtez d'augmenter en permanence la puissance et le coût de votre infra : soyez vigilants sur votre filtrage et bannissez correctement tout crawler intempestif.

- Attention aux différents outils de mesure qui, pour générer un rapport, peuvent déclencher des nuées ardentes de hits. Planifiez vos analyses SEO en dehors des heures de pointe.

- Prudence dans l'usage de vos LLM et des données / scripts que vous partagez. Ne partagez jamais d'identifiants de connexion, même locaux.

- Vérifiez les User-Agents : ne faites jamais confiance au User-Agent seul. Implémentez une vérification reverse DNS pour les bots critiques.

- Analysez vos logs régulièrement pour identifier les bots les plus gourmands et adapter votre stratégie de filtrage.

- Bloquez les indésirables : identifiez et bloquez les bots à risque CRITICAL comme Bytespider, MJ12bot, DotBot qui ne respectent pas les règles.

Vous l'aurez compris, avant de sortir l'artillerie lourde pour gérer une masse de trafic, il est primordial d'identifier le bon du mauvais trafic et dompter l'activité des robots sur votre infrastructure.

Notre équipe d'experts a conçu pour cela une nouvelle série d'outils permettant d'analyser en live et sur tout l'historique de votre site, l'activité de ce dernier et vous fournir un diagnostic de performances en quelques jours avec des mesures et actions applicables immédiatement.

Aucun tableau de bord, juste une mise en œuvre, un diagnostic et des résultats immédiats.

📥 Pour en savoir plus, téléchargez notre livre blanc complet "Ce que les crawlers font pendant que vous dormez" avec toutes les analyses détaillées, méthodologies et recommandations opérationnelles.

.jpg)